(20250625記: 当HP記載の技術は陳腐化している and/or 記述が冗長なので近々大きく更新予定です。発展途上の技術であること、ご承知おきください。)

(20250625記: 勉強会 を開催予定です。)

関数型玩具製作所は、最新のテクノロジーを駆使して実用的な玩具を開発しています。

現在は「難解な文章」を攻略する技術を開発しています。

現在は「難解な文章」を攻略する技術を開発しています。

我々は文章理解を支援するための言語拡張ソフトウェア(テキストトランスフォーマー)を開発しました。

これにより、複雑な文章を簡単に理解できるようになります。

上でカタカタ動いているのは、そのデモ動画です。

難解な文章を出力している際のChatGPTに適用しています

言語拡張ソフトウェアは3つの機能で構成されています。

しかしデモ動画では3つの機能が同時に適用されています。

理解のために、3つの機能を順を踏んで確認できる事例を以下にご用意しました。

以下は教科書の冒頭に見られる文章の例です。

ちょっとしたクイズですが、「各章で扱われる題材」を把握してみてください。

「各章がそれぞれどう違うか」にフォーカスしてください。

そしてクイズが解けたら、ボタンをクリックしてみてください。

3段階で進化するプロセスを体験できます。

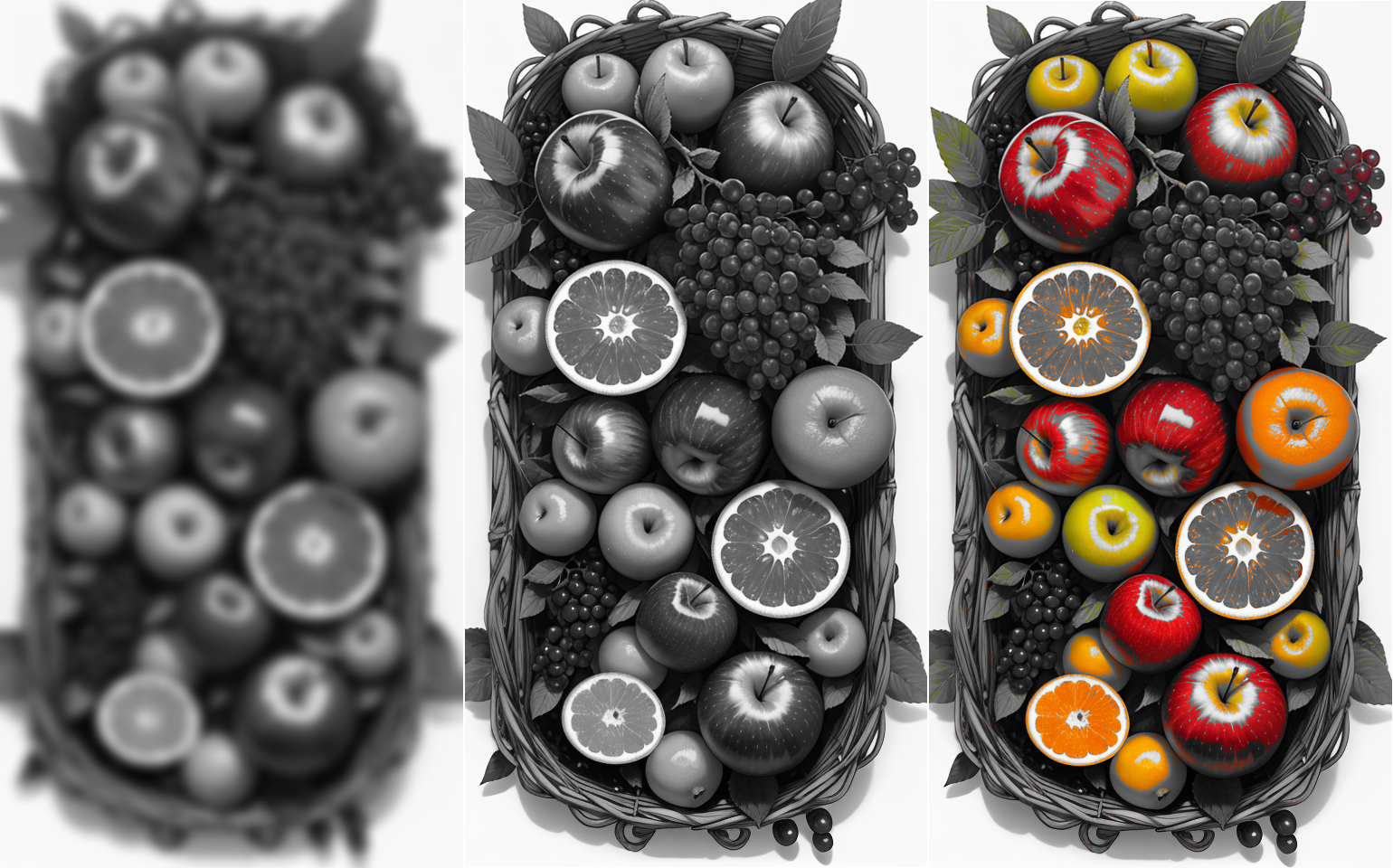

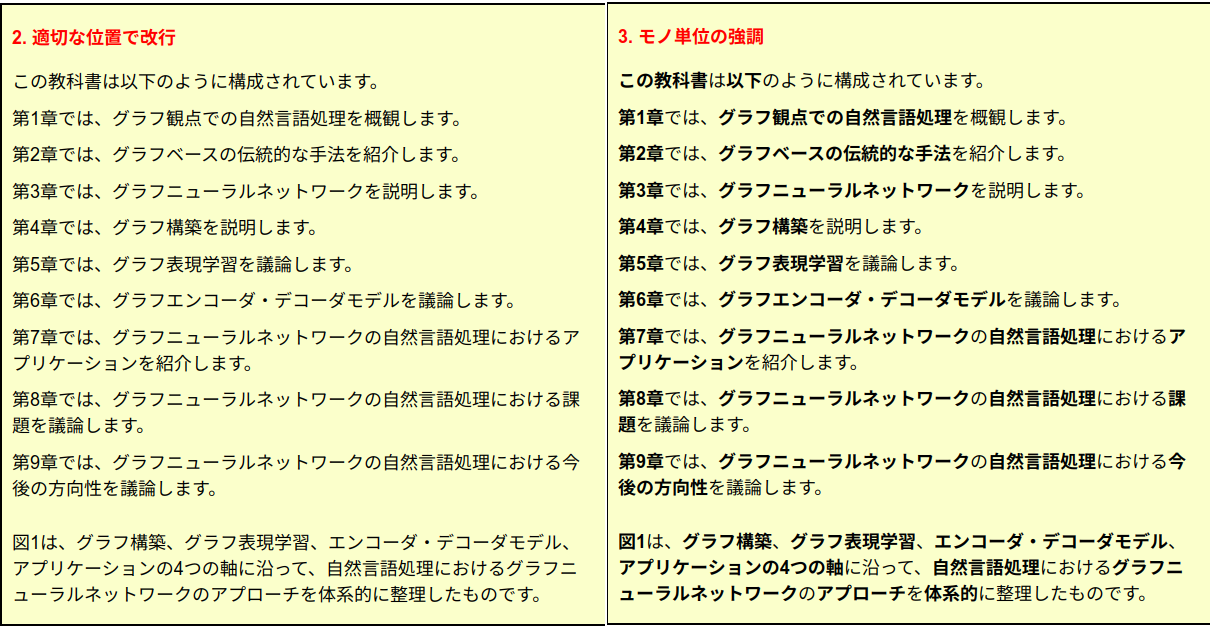

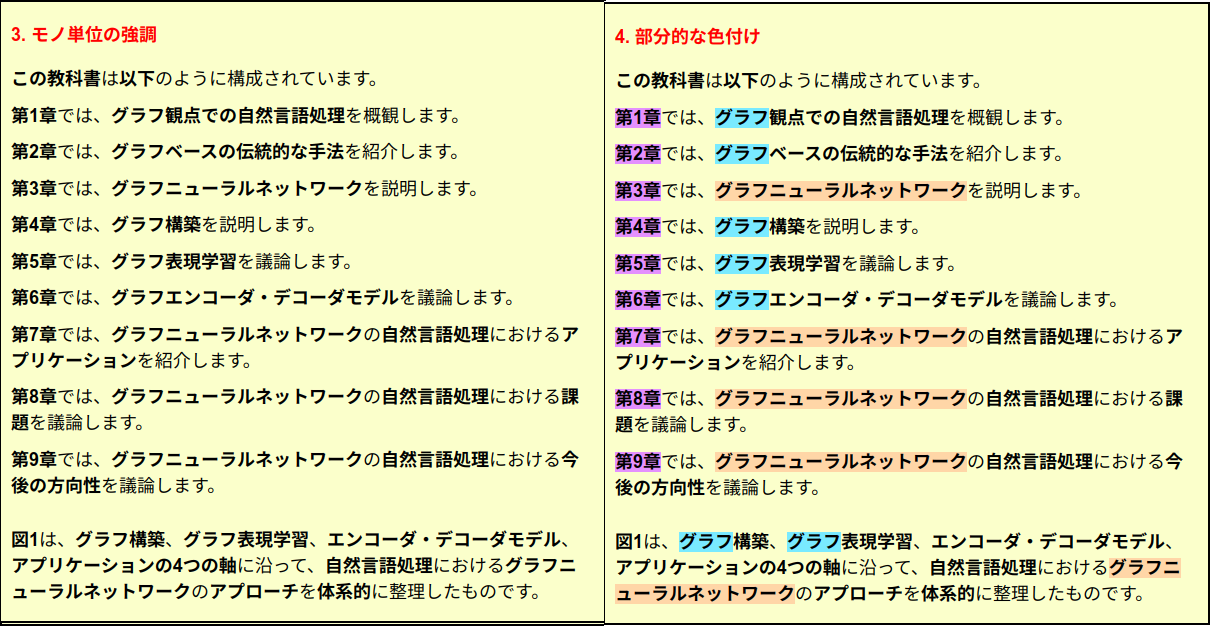

1. 初期状態 → 2. 適切な位置で改行 →

3. モノ単位の強調 → 4. 重要語の色付け

(タブレット、パソコンを推奨)

1. 初期状態

この教科書は以下のように構成されています。 第1章では、グラフ観点での自然言語処理を概観します。 第2章では、グラフベースの伝統的な手法を紹介します。 第3章では、グラフニューラルネットワークを説明します。 第4章では、グラフ構築を説明します。 第5章では、グラフ表現学習を議論します。 第6章では、グラフエンコーダ・デコーダモデルを議論します。 第7章では、グラフニューラルネットワークの自然言語処理におけるアプリケーションを紹介します。 第8章では、グラフニューラルネットワークの自然言語処理における課題を議論します。 第9章では、グラフニューラルネットワークの自然言語処理における今後の方向性を議論します。

図1は、グラフ構築、グラフ表現学習、エンコーダ・デコーダモデル、アプリケーションの4つの軸に沿って、自然言語処理におけるグラフニューラルネットワークのアプローチを体系的に整理したものです。

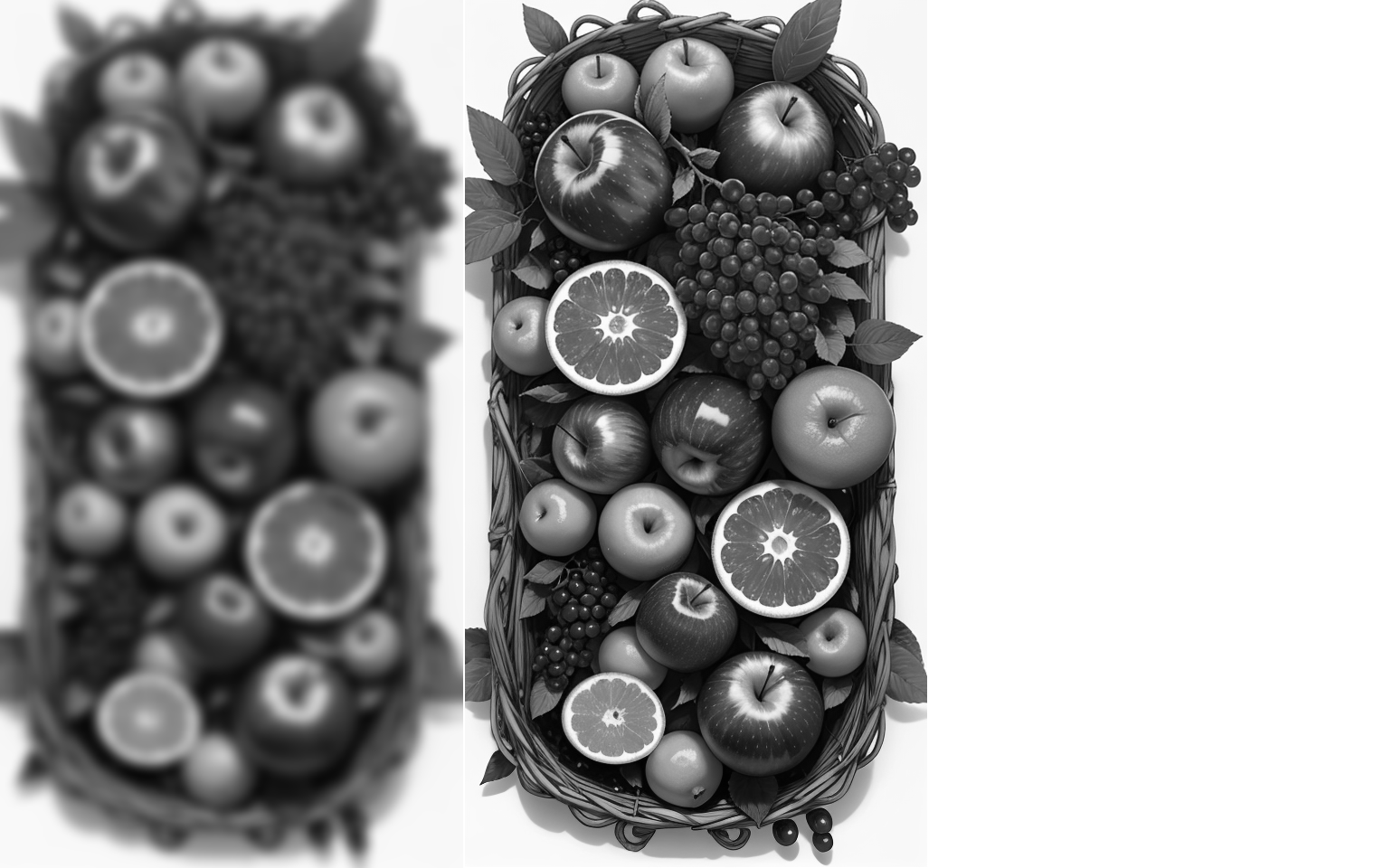

2. 適切な位置で改行

この教科書は以下のように構成されています。

図1は、グラフ構築、グラフ表現学習、エンコーダ・デコーダモデル、アプリケーションの4つの軸に沿って、自然言語処理におけるグラフニューラルネットワークのアプローチを体系的に整理したものです。

3. モノ単位の強調

この教科書は以下のように構成されています。

図1は、グラフ構築、グラフ表現学習、エンコーダ・デコーダモデル、アプリケーションの4つの軸に沿って、自然言語処理におけるグラフニューラルネットワークのアプローチを体系的に整理したものです。

4. 重要語の色付け

この教科書は以下のように構成されています。

図1は、グラフ構築、グラフ表現学習、エンコーダ・デコーダモデル、アプリケーションの4つの軸に沿って、自然言語処理におけるグラフニューラルネットワークのアプローチを体系的に整理したものです。

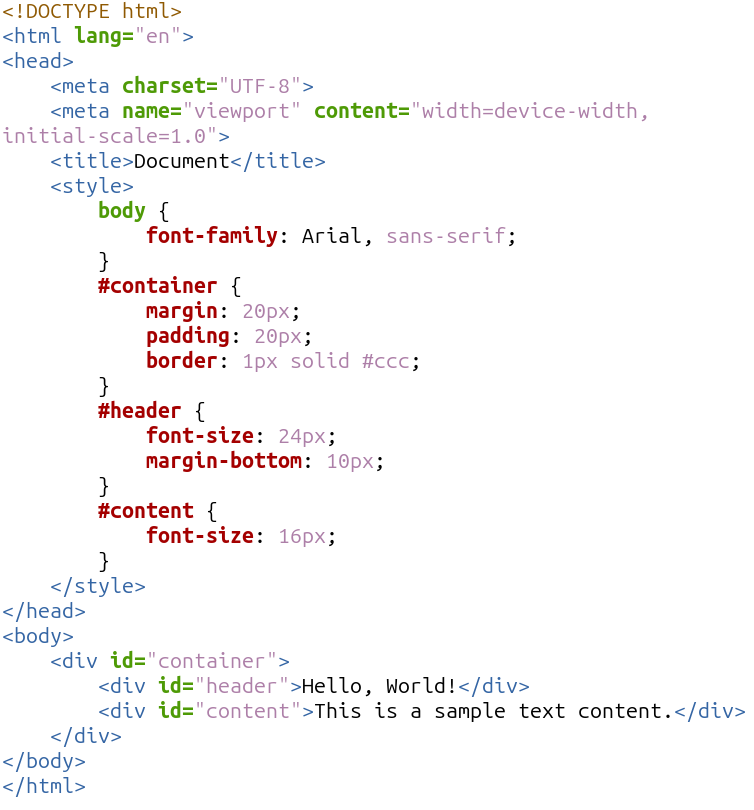

1. 初期状態

2. 適切な位置で改行

2. 普段見ている文章

3. モノ単位の強調

4. 重要部分の色付け

ぜひ皆さんにもこの感覚を知っていただき、自信を持ってこの拡張を利用していただきたいと思います。

ぜひ皆さんにもこの感覚を知っていただき、自信を持ってこの拡張を利用していただきたいと思います。

この拡張機能は、特にChatGPTやWikipediaの文章と相性が良いです。

なぜこの拡張機能が特定の文章と相性が良いのかについては、理論的な説明で詳しく触れます。

「難解な文章」であればあるほど、「簡単」に理解できるようになるという興味深い事実があります。